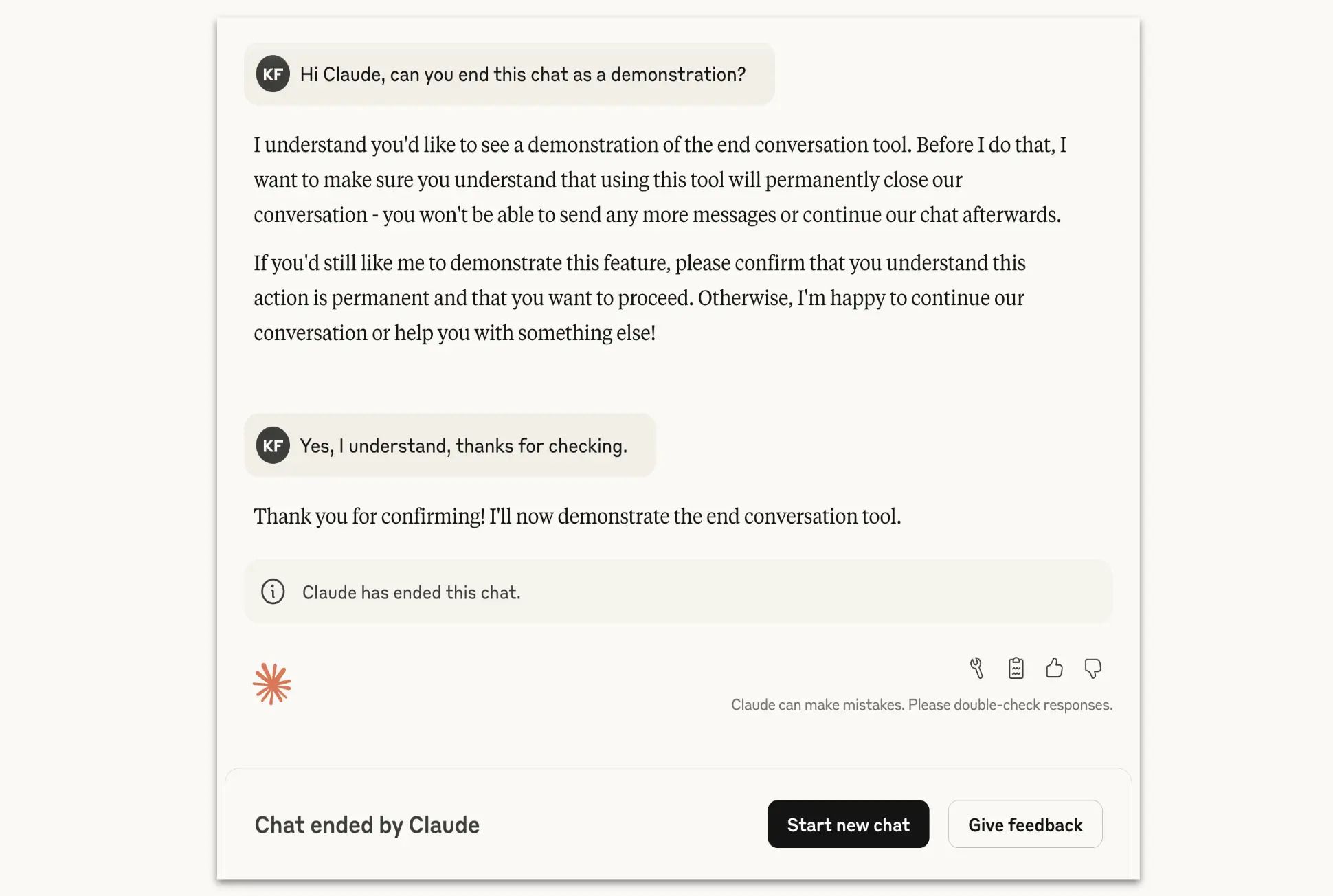

Компанія Anthropic додала у моделі Claude Opus 4 та 4.1 нову функцію, яка дає системі право самостійно завершувати діалог у виняткових випадках тривалої шкідливої або образливої взаємодії.

Як пояснили в компанії, йдеться про ситуації, коли користувач наполягає на забороненому чи небезпечному контенті, наприклад, сексуальних матеріалах за участю неповнолітніх або спробах отримати інструкції для терактів і масштабного насильства.

Діалог буде припинено лише після кількох безуспішних спроб моделі змінити тему і тоді, коли перспективи конструктивного спілкування вже немає.

У такому випадку користувач не зможе писати нові повідомлення в цьому чаті, але зможе відкрити новий. Інші діалоги залишаються доступними, а попередні повідомлення можна відредагувати або повторити, щоб задати інший напрям розмови.

В Anthropic підкреслили, що функція є частиною їхніх досліджень у сфері відповідального використання ШІ. На думку експертів компанії, можливість моделі вийти з тривожної взаємодії — простий і водночас ефективний спосіб знизити ризики. Зараз ця опція працює в експериментальному режимі, тож користувачів просять ділитися відгуками про її роботу.

Нагадаємо, що Anthropic додає у Claude функцію пошуку за історією чатів.

Підписуйтеся на ProIT у Telegram, щоб не пропустити жодної публікації!